-

【国盛计算机】大厂Capex加速增长

无名8 / 今天13:20 发布

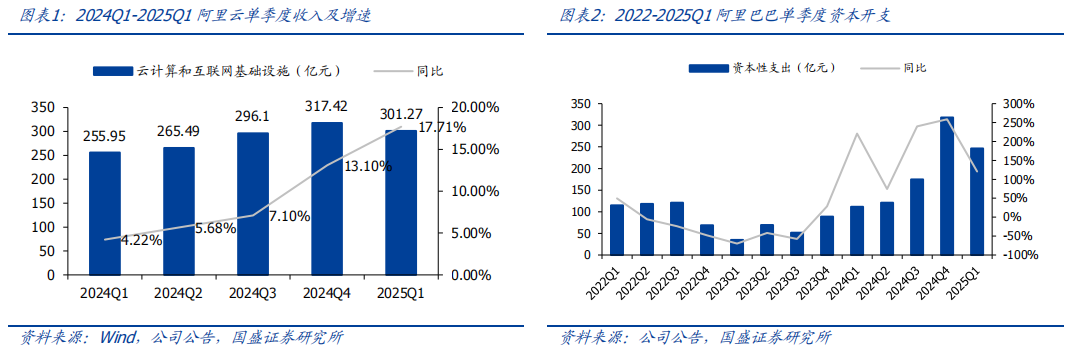

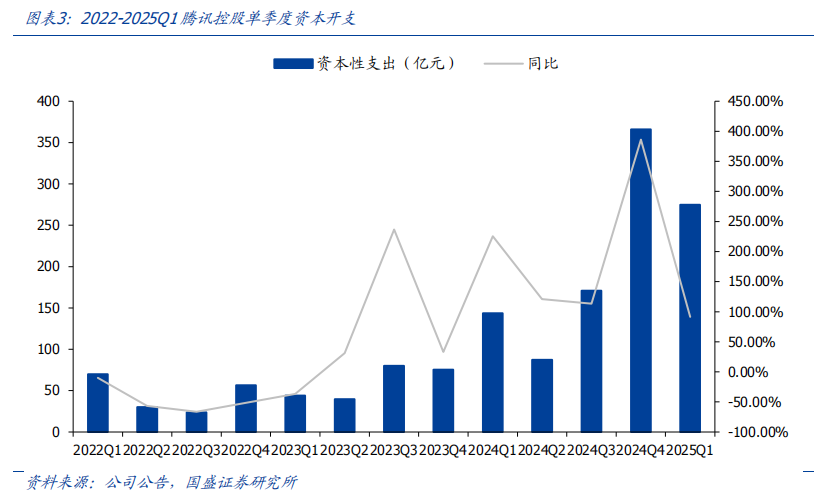

核心观点 阿里、腾讯Capex实质更乐观,AI基建正式启动。推理端对高性能计算的需求快速释放,阿里、腾讯等大厂Capex持续扩张,云上游上行周期正式启动。1)2025Q1阿里资本开支为246.12亿元,同比增长120.68%;2025Q1阿里云表现亮眼,收入301.27亿元,同比增长17.71%。同时,根据阿里巴巴资本性支出承诺事项,2024年3月31日及2025年3月31日已签约但尚未计提的资本性支出承诺总金额分别为183.72亿人民币及453.21亿人民币,之前季度报告基本不披露此数据,资本开支承诺金额超预期。2025年2月24日,阿里CEO吴泳铭宣布,未来三年阿里将投入超3800亿元用于建设云和AI硬件基础设施,产业端持续释放积极信号。2)2025Q1腾讯资本开支 274.76亿,相比之下,去年同期2024Q1约144亿,同比+91.35%。2025年3月19日,腾讯控股公告,2024年第四季AI项目发展所涉及的资本开支390亿元,公司预计在2025年进一步增加Capex,预期Capex占收入的比例为低两位数百分比。我们认为,云大厂自上而下资本开支指引,有望进一步强化市场对于算力投资前景的信心。

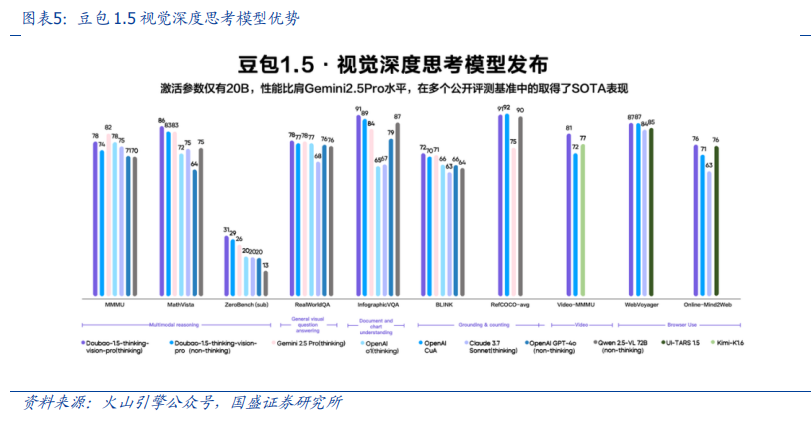

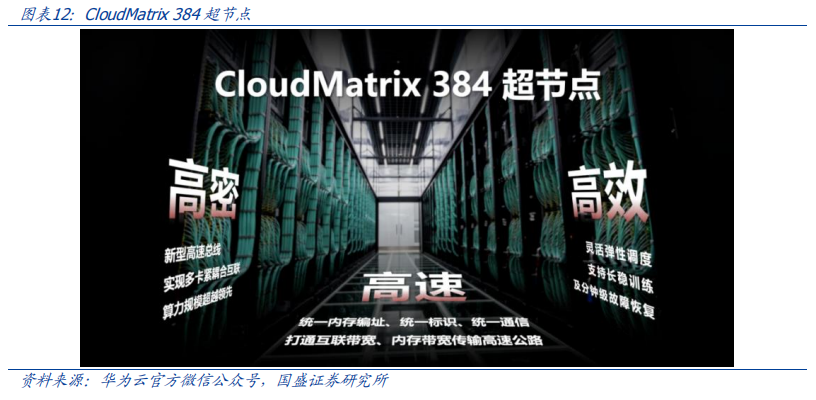

云大厂能力全面升级,加速AI落地。1)5月13日,在FORCE LINK AI创新巡展·上海站,火山引擎发布Seedance 1.0 lite、豆包1.5·视觉深度思考模型,升级豆包·音乐模型。6月11-12日,火山引擎将召开2025 FORCE原动力大会春季会议,有望迎来更多AI落地惊喜。2)4月9日,阿里云在北京召开AI势能大会,AI和云计算基础设施全面升级。算力上,阿里云第九代ECS开启商业化,算力最高提升20%、价格较上一代再降5%;存储上,文件存储CPFS面向AI智算能力再升级,吞吐、缓存、权限能力均有提升;运维上,跨域网络SLA提升至99.995%,网络智能服务NIS已推出;管控上,“灵骏”可主动发现故障并“自愈”,一个月内的万卡有效训练时长占比超93%;推理上,人工智能平台PAI面向MoE架构及推理模型全面升级,首Token生成响应时间降低92%,端到端服务吞吐提升91%,千万级用户活跃用户场景的KV Cache命中率可提升10倍以上;Agent部署:阿里云百炼上线业界首个全生命周期MCP服务,5分钟即可快速搭建一个专属MCP Agent,同时预告AI Agent Store的愿景。2)4月10日,华为云生态大会2025于安徽芜湖召开。在算力架构上继续创新,推出CloudMatrix 384超节点,高密、高速、高效;同时,继续沉淀行业Know-how,推动盘古大模型的落地;生态亦是华为云的建设重点,开发者规模已超1200万。

算力是Agent爆发的前提,应用支撑中长期成长。以LLM为核心驱动的Agent背后蕴含庞大的算力需求:1)Agent通过API调用、网页浏览等方式接入外部数据和多轮模型调用带来的长上下文。2)Agent执行任务验证带来算力开销,为确保任务执行的准确性、可靠性与合规性,如Manus AI的三重校验体系不可避免地消耗大量算力。3)多模态发展趋势下,Agent需处理整合文本、图像、音频等多种类型数据。4)Agent能力日益增强的带来的用户调用激增,为保障用户体验,Agent服务提供商需预留应对用户流量波动的冗余算力。5)除了用户端的推理需求,模型训练阶段对更大规模数据和模型参数量的需求也对算力提出了更高要求。我们认为,从模型训练到服务推理,从应对高并发访问到保障服务稳定性,算力已成为支撑Agent发展的关键基础设施和核心瓶颈。

:

算力:寒武纪、海光信息、阿里巴巴、奥飞数据、协创数据、海南华铁、云赛智联、潍柴重机、科华数据、利通电子、大位科技、玉柴国际、亿田智能、宏景科技、东阳光、弘信电子、圣阳股份、润建股份、深信服、神州数码、深桑达、品高股份、金山云、南都电源、云天励飞、优刻得、云从科技、浪潮信息、中科曙光、太极股份、首都在线、杭钢股份、数据港、南兴股份、华策影视、顺网科技、恒为科技、网宿科技、杰创智能、朗科科技等。

Agent:金山办公、泛微网络、金蝶国际、鼎捷数智、拓尔思、用友网络、宇信科技、京北方、中科金财、致远互联、金桥信息、汉得信息、朗新集团、上海钢联、新致软件、同花顺、信雅达、萤石网络、润达医疗、中科金财、恒生电子、星环科技、卫宁健康、创业慧康、软通动力、光云科技、科大讯飞、万兴科技、海天瑞声、创业黑马、迈富时、小商品城、金证股份、顶点软件、朗新集团、晶泰控股、佳发教育、嘉和美康、新大陆、新开普等。

垃圾发电:旺能环境、盈峰环境、瀚蓝环境、军信股份等。

互联网大厂AI链:寒武纪、恒玄科技、孩子王、天键股份、润欣科技、实丰文化、乐鑫科技、萤石网络、中芯国际、润泽科技、欧陆通、华懋科技、浪潮信息、中兴通讯、中科曙光、兆易创新、国光电器、法本信息、亚康股份、申菱环境、兆龙互连等。军工AI:能科科技、品高股份、普天科技、海格通信等。

风险提示:AI技术迭代不及预期风险;经济下行超预期风险;行业竞争加剧风险。

报告正文 一、阿里、腾讯Capex实质更乐观,AI基建正式启动 在推理端,随着算力投资ROI提升及大模型能力的不断突破,AI模型性能有望在今年迎来质变,我们看好由推理应用带来的云计算需求持续扩张。

1)阿里资本开支承诺金额超预期,阿里云增速亮眼。

2025Q1阿里资本开支为246.12亿元,同比增长120.68%;阿里云收入301.27亿元,同比增长17.71%。同时,根据阿里巴巴资本性支出承诺事项,于2024年3月31日及2025年3月31日,已签约但尚未计提的资本性支出承诺总金额分别为183.72亿人民币及453.21亿人民币,之前季度报告基本不披露此数据。

未来三年阿里将投入超3800亿元用于AI基建,产业端正展现出积极信号。2025年2月24日,阿里CEO吴泳铭宣布,未来三年阿里将投入超3800亿元用于建设云和AI硬件基础设施。云大厂自上而下资本开支指引有望强化市场对于算力投资前景的信心。

2)腾讯:资本开支符合预期,国内AI基建正式启动。2025Q1腾讯资本开支 274.76亿,相比之下,去年同期2024Q1约144亿,同比+91.35%。2025年3月19日,腾讯控股公告,2024年第四季AI项目发展所涉及的资本开支390亿元,公司预计在2025年进一步增加Capex,预期Capex占收入的比例为低两位数百分比。

二、云大厂能力全面升级,加速AI应用落地 1、字节:2025 FORCE原动力大会召开在即

6月火山引擎2025 FORCE原动力大会召开在即,AI应用落地如火如荼。5月13日,在 FORCE LINK AI 创新巡展·上海站,火山引擎发布豆包·视频生成模型 Seedance 1.0 lite、豆包1.5·视觉深度思考模型,升级豆包·音乐模型。同时,Data Agent 正式亮相、Trae 接入豆包深度思考模型并全新升级。火山引擎正在以更强大的模型矩阵、更丰富的智能体工具,帮助企业打通从业务到智能体的应用链路。巨人网络、礼来制药等行业龙头企业,也在会上分享了在生产实践中运用大模型的成果和经验。

6月11-12日,火山引擎将召开2025 FORCE原动力大会春季会议,有望迎来更多AI落地惊喜。

l 5月13日全新发布的豆包视频生成模型 Seedance 1.0 lite,支持文生视频、图生视频,视频生成时长支持5s、10s,分辨率提供480P、720P。企业用户可在火山方舟平台使用该模型 API,个人用户也可在豆包 APP、即梦体验。

l 豆包1.5·视觉深度思考模型(Doubao-1.5-thinking-vision-pro),激活参数仅20B,但具备强大的多模态理解和推理能力,在60个公开评测基准中,有38个取得 SOTA 表现,在视频理解、视觉推理、GUI Agent 能力等方面均处于第一梯队。

l 豆包·音乐模型升级:不仅支持英文歌曲创作,还可以通过理解视频,自动适配纯音乐 BGM。目前豆包·音乐模型已全量上线,个人和企业用户可在海绵音乐、火山引擎官网体验。

l Data Agent正式落地:Data Agent是火山引擎推出的企业数据全场景智能体,具备主动思考、洞察、分析、行动能力,可以帮助企业挖掘数据资产价值,功能覆盖数据分析、智能营销等关键领域。在数据分析上,Data Agent 能融合企业内结构化与非结构化数据,结合联网知识,精准理解业务需求,快速生成专业深度研究报告。通过自动化制定分析方案、追溯指标波动、运用自助分析工具及搭建预警系统,实现数据处理全流程智能化,将复杂报表生成的时间从2天缩短至30分钟,显著提升数据获取与决策效率。在智能营销领域,Data Agent 实现从策略制定到执行优化的全链路闭环管理,高效完成人群圈选与策略拆解,基于个性化引擎实现精准营销。此外,其智能会话辅助与自动复盘优化功能,可不断提升转化率与客户满意度,动态迭代营销策略。

2、阿里云:AI和云计算基础设施全面升级

为加速AI应用在企业市场落地,4月9日,阿里云在北京召开AI势能大会。

算力:第九代ECS开启商业化,算力最高提升20%、价格较上一代再降5%。1)基于自研“飞天+CIPU”技术架构,阿里云ECS 9代Intel实例算力较上代提升最高达20%,通过3.6GHz全核睿频与504MB超大L3缓存,可保障高并发场景流畅响应,并结合AMX矩阵加速技术,可显著提升AI数据预处理场景的执行效率。此外,在安全能力上新实例支持TDX机密虚拟机,大大降低了机密计算的使用门槛。2)4月9日,9代Intel企业级实例全面降价,在上一代基础上再降5%,并正式开启商业化售卖,让更多的客户以更划算的价格享受更高性能的云计算服务。

存储:高性能存储优化,训练和推理效率再提升。文件存储CPFS实现了面向AI智算能力的升级。单客户端吞吐性能达40GB/s,单计算节点缓存吞吐15GB/s,支持可线性扩展的分布式缓存。提供容量型存储池,有效降低温冷数据成本,支持高达100GB/s的数据流动。此外,CPFS发布目录级配额,通过Access Point简化数据访问权限管理。

运维:跨域网络SLA提升至99.995%,网络智能服务NIS已推出。1)阿里云ZooRoute技术,把跨域网络SLA提升到99.995%,当前已集成到阿里云跨域,专线和互联网接入网络等场景。2)网络智能服务NIS是阿里云打造的基于AIOps与行业大数据的智能运维工具集,在用户上云的全生命周期提供开箱即用的网络深度可观测能力,包括最新的流量分析NPM、网络架构巡检等。

管控:“灵骏”可主动发现故障并“自愈”,万卡有效训练时长占比超93%。从训练到推理,基于GPU的加速计算为AI大模型全面升级。现在,阿里云灵骏智能计算平台可实现智能化感知故障,主动发现故障占比高达96%,并且通过自动化故障处置的“自愈”体系技术,将任务中断恢复时间从小时级压缩至分钟级。在万卡级超大规模训练中,一个月内灵骏GPU有效训练时长占比超过93%。

推理:人工智能平台PAI,面向MoE架构及推理模型全面升级。在模型推理阶段,PAI-EAS具备负载感知的PD分离架构,结合MoE分布式推理调度引擎Llumnix,能显著提升推理速度和资源利用率,首Token生成响应时间降低92%,端到端服务吞吐提升91%。同时PAI-EAS推出高性能KV Cache缓存服务,千万级用户活跃用户场景的KV Cache命中率可提升10倍以上。

数据:瑶池数据库产品上新,支持In-DB AI、开箱即用。瑶池数据库核心产品已全面支持In-DB AI功能,通过内嵌“模型即算子”能力,让数据与AI贴得更近,实现用户数据内循环、不出域,显著提升推理效率。云原生数据库PolarDB forAI功能升级,用户通过SQL语句即可调用内置大模型,提供开箱即用的AI能力。

Agent:上线业界首个全生命周期MCP服务,预告Agent Store愿景。1)为了让AI Agent有“更聪明的大脑”、“更丰富的交互”,4月9日,阿里云百炼上线业界首个全生命周期MCP服务,无需用户管理资源、开发部署、工程运维等工作,5分钟即可快速搭建一个专属MCP Agent,大幅降低Agent的开发门槛。百炼平台首批上线了高德、无影、Fetch、Notion等50多款阿里巴巴集团和三方MCP服务,覆盖生活信息、浏览器、信息处理、内容生成等领域。2)阿里云还预告了AI Agent Store的愿景,通过Agent Store这种创新模式,把阿里巴巴集团和生态伙伴的Agent向外开放,让各行各业的人都可以拥有自己专属的助理。

生态:“繁花计划”启动,未来三年目标百万家客户、百亿元商机。在AI势能峰会上,阿里云发布AI生态伙伴计划——“繁花计划”,并推出AI应用与服务市场。未来三年,阿里云将在基础设施,模型,数据,工具,应用,交付六大领域与生态伙伴一起服务百万云上客户,拓展百亿商机。

3、华为云:创新算力架构,全新生态战略

4月10日,华为云生态大会2025于安徽芜湖召开。

创新算力架构,推出CloudMatrix 384超节点。面向AI时代的海量算力需求,华为云基于“一切可池化、一切皆对等、一切可组合”的新型高速互联总线推出CloudMatrix 384超节点,实现从服务器级到矩阵级的资源供给模式转变。CloudMatrix 384具备“高密”“高速”“高效”的特点,通过全面的架构创新,在算力、互联带宽、内存带宽等方面实现全面领先。

沉淀行业Know-how,推动盘古大模型在行业场景落地。1)面向行业多样化场景需求,华为云持续沉淀行业Know-How,盘古大模型已在30多个行业、400多个场景中落地,持续聚焦行业解难题、做难事。2)同时,盘古大模型与华为终端的合作也取得进展,新一代折叠屏旗舰Pura X搭载的全新智慧助手小艺受到用户肯定。

坚定投入生态建设,华为开发者规模超1200万。1)秉持共建、共享、共赢理念,华为云坚定打造云生态体系。目前,华为开发者规模超1200万,伙伴数量超4.5万,云商店应用数量超1.2万。2)本次生态大会期间,科大讯飞、奇瑞汽车、硅基流动、面壁智能等客户伙伴,分享了与华为云的生态合作历程、联合营销和商业落地等情况,展示了华为云生态体系的共建成果。

三、算力是Agent爆发的前提,支撑中长期成长 Agent对算力的需求极其庞大,无论是训练更强大的Agent模型,还是支撑海量用户的高并发访问,亦或是确保Agent执行任务的准确可靠,都离不开底层算力的强力支撑。Agent对算力需求巨大的几个核心原因包括:

1、Agent需要处理长上下文和接入外部数据。

Agent的上下文窗口长度以及接入外部数据的能力直接关系到Agent能够处理任务的复杂度和深度,这种能力的提升直接关联到巨大的计算需求。计算需求增长对底层硬件(主要是GPU)提出了极高的要求,不仅需要更多的计算单元,还需要更大的显存来存储模型参数和中间计算结果。更长的上下文窗口意味着模型可以处理和记住更多的信息。IBM的解释中明确指出,LLM的上下文窗口(或上下文长度)是模型在任何时候可以考虑或“记住”的文本量,以词元为单位。LLM的上下文窗口可被视为其工作记忆。它决定了LLM在不遗忘先前对话细节的情况下可以进行多长时间的对话。它还决定了一次可以处理的文档或代码样本的最大大小。当提示、对话、文档或代码库超过人工智能模型的上下文窗口时,必须对其进行截断或总结,模型才能继续处理。一般来说增加LLM的上下文窗口大小意味着更高的准确性、更少幻觉、更连贯的模型响应、更长的对话以及分析更长数据序列的能力提高。增加上下文长度通常需要增加算力要求,导致成本增加。

当用户与Agent进行多轮对话,或者要求Agent处理长文档、分析大量数据时,模型需要维持庞大的上下文信息。不仅仅是用户输入的文本,还可能包括系统提示、通过检索增强生成(RAG)从外部数据源获取的补充信息等。所有这些信息都需要在模型的工作记忆中占据空间。Agent接入外部数据的能力,例如通过API调用、网页浏览、数据库查询等方式获取实时或特定领域信息,进一步加剧了算力消耗。Agent执行这些外部调用本身就需要计算资源,而获取到的外部数据往往需要整合到当前的上下文中,再次增加了上下文的长度和处理的复杂度。

2、Agent执行任务验证带来的算力开销

为了确保Agent执行任务的准确性、可靠性和合规性,复杂的验证过程成为许多高级Agent架构中不可或缺的一环。据51cto,以Manus AI为例,其技术架构中包含一个专门的验证模块,验证模块通过三重校验体系保障输出可靠性:逻辑验证器检测任务链的因果合理性;事实核查器交叉比对多信源数据真实性;合规审查器确保输出符合法律法规。在医疗咨询、金融分析等对准确性和合规性要求极高的场景中,验证模块发挥着关键作用,如在医疗咨询时同步验证医学指南、最新论文和临床数据,生成置信度评分,让输出结果精准且可靠。

执行这些验证步骤需要额外的计算资源,是为了提升结果质量和可靠性而进行的投入。我们认为Agent越智能、越可靠,其内置的验证和修正机制往往越复杂,对算力的需求也就越大。

3、多模态的发展会带来更大算力需求

随着技术进步,Agent正朝着多模态的方向发展,即能够处理和整合多种类型的数据,如文本、图像、音频、视频等。多模态的发展使得Agent能够在更广泛的应用场景中发挥作用,为用户提供更加丰富和全面的交互体验,但同时也带来了更大的算力需求。以一个智能客服Agent为例,它不仅需要理解用户的文本提问,还可能需要识别用户上传的图片或语音消息。为了处理这些多模态数据,Agent需要大量的计算资源,

4、算力瓶颈影响Agent服务的用户体验在用户量激增、模型复杂度提升、应用场景多样化的背景下,算力瓶颈问题日益凸显,具体表现为服务响应延迟、服务不稳定甚至服务中断等情况,导致用户体验受损,虽然可以通过优化API调用方式(如批量请求、异步请求)等方法缓解,但根本原因在于瞬时或持续的算力需求超出了服务提供商的承载能力。

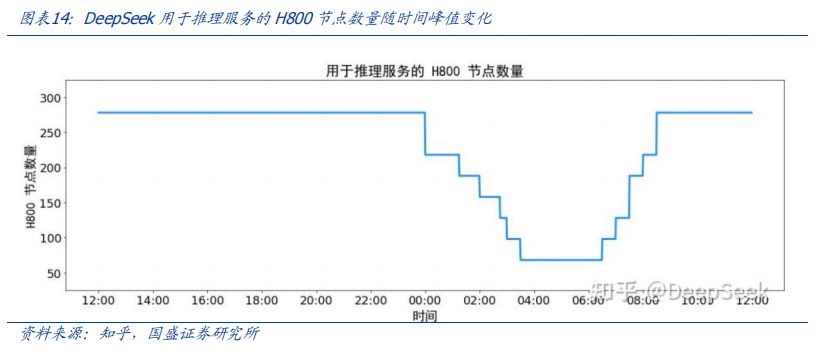

如据新京报贝壳财经记者测试发现Manus回答问题一般耗时15分钟,根据任务难度的不同,Manus执行任务的时间也不同,如对“设计采访提纲与视频采访脚本方案”等几项文字类任务,Manus的执行时间约为15分钟至20分钟,而对于“设计金融科普互动产品”这项涉及网页交互的任务,Manus耗时31分钟。极客公园测试,用扣子的探索模式制定一份日本旅行攻略,做出这份旅行攻略的时间在10分钟以上,同时为了保证用户体验Agent服务需要留出一定应对用户流量波动的冗余算力。用户对服务的访问量往往具有不确定性,会因各种因素如节假日、特殊事件、营销活动等出现峰值。DeepSeek官方在知乎发布的技术报告指出,由于白天的服务负荷高,晚上的服务负荷低,因此DeepSeek实现了一套机制,在白天负荷高的时候,用所有节点部署推理服务。晚上负荷低的时候,减少推理节点,以用来做研究和训练。但并非所有Agent服务提供商都有训练模型等需求可以充分利用闲时算力,因此能满足用户峰值的算力必然会存在一定的冗余。

5、算力需求不仅体现在用户端的推理服务上,也体现在模型训练阶段。训练更大、更强的Agent基础模型需要海量的算力支持。当下大模型的参数规模和训练数据量规模都非常庞大。以阿里的Qwen模型为例,4月29日阿里开源的Qwen3系列模型中Qwen3-235B-A22B有2350多亿数、220多亿激活参数。在预训练方面,Qwen3的数据集相比Qwen2.5有了显著扩展。Qwen2.5是在18万亿个token上进行预训练的,而Qwen3使用的数据量几乎是其两倍,达到了约36万亿个token,涵盖了119种语言和方言。在后训练阶段,为了开发能够同时具备思考推理和快速响应能力的混合模型,阿里实施了一个包括(1)长思维链冷启动(2)长思维链强化学习(3)思维模式融合(4)通用强化学习的四阶段训练流程。

综上所述,基于大语言模型的Agent之所以对算力有着巨大的需求,是由其技术特性和当前的发展阶段共同决定的。更长的上下文处理能力、接入外部数据的需求、日益增强的功能带来的用户调用频率激增、确保结果可靠性的复杂验证机制,以及当前Agent技术和应用的高速扩张,都对底层算力提出了极高的要求。从模型训练到服务推理,从应对高并发访问到保障服务稳定性,算力已成为支撑Agent发展的关键基础设施和核心瓶颈。四、 算力:寒武纪、海光信息、阿里巴巴、奥飞数据、协创数据、海南华铁、云赛智联、潍柴重机、科华数据、利通电子、大位科技、玉柴国际、亿田智能、宏景科技、东阳光、弘信电子、圣阳股份、润建股份、深信服、神州数码、深桑达、品高股份、金山云、南都电源、云天励飞、优刻得、云从科技、浪潮信息、中科曙光、太极股份、首都在线、杭钢股份、数据港、南兴股份、华策影视、顺网科技、恒为科技、网宿科技、杰创智能、朗科科技等。

Agent:金山办公、泛微网络、金蝶国际、鼎捷数智、拓尔思、用友网络、宇信科技、京北方、中科金财、致远互联、金桥信息、汉得信息、朗新集团、上海钢联、新致软件、同花顺、信雅达、萤石网络、润达医疗、中科金财、恒生电子、星环科技、卫宁健康、创业慧康、软通动力、光云科技、科大讯飞、万兴科技、海天瑞声、创业黑马、迈富时、小商品城、金证股份、顶点软件、朗新集团、晶泰控股、佳发教育、嘉和美康、新大陆、新开普等。

垃圾发电:旺能环境、盈峰环境、瀚蓝环境、军信股份等。

互联网大厂AI链:寒武纪、恒玄科技、孩子王、天键股份、润欣科技、实丰文化、乐鑫科技、萤石网络、中芯国际、润泽科技、欧陆通、华懋科技、浪潮信息、中兴通讯、中科曙光、兆易创新、国光电器、法本信息、亚康股份、申菱环境、兆龙互连等。军工AI:能科科技、品高股份、普天科技、海格通信等。

水晶球APP

高手云集的股票社区

X

公安备案号 51010802001128号

公安备案号 51010802001128号