-

ASIC芯片市场现状、技术进展及发展趋势

神力 / 01月17日 12:57 发布

Q:算力技术方面有哪些变化,尤其是在大规模部署时面临的问题?

A:算力技术在过去两年中有显著变化,例如NVL36、NVL72、IB以及CPO、LPO等技术的出现。在大规模部署中,面临的问题包括前期的漏液问题、同连接PCB的问题等。同时,从NV(英伟达)的视角看,主要是一个性价比问题,即GPU功耗大、价格昂贵,导致在推理侧应用时成本过高。例如,910C和DB200中使用的1500万镁锌片表明成本和功耗仍难以解决。

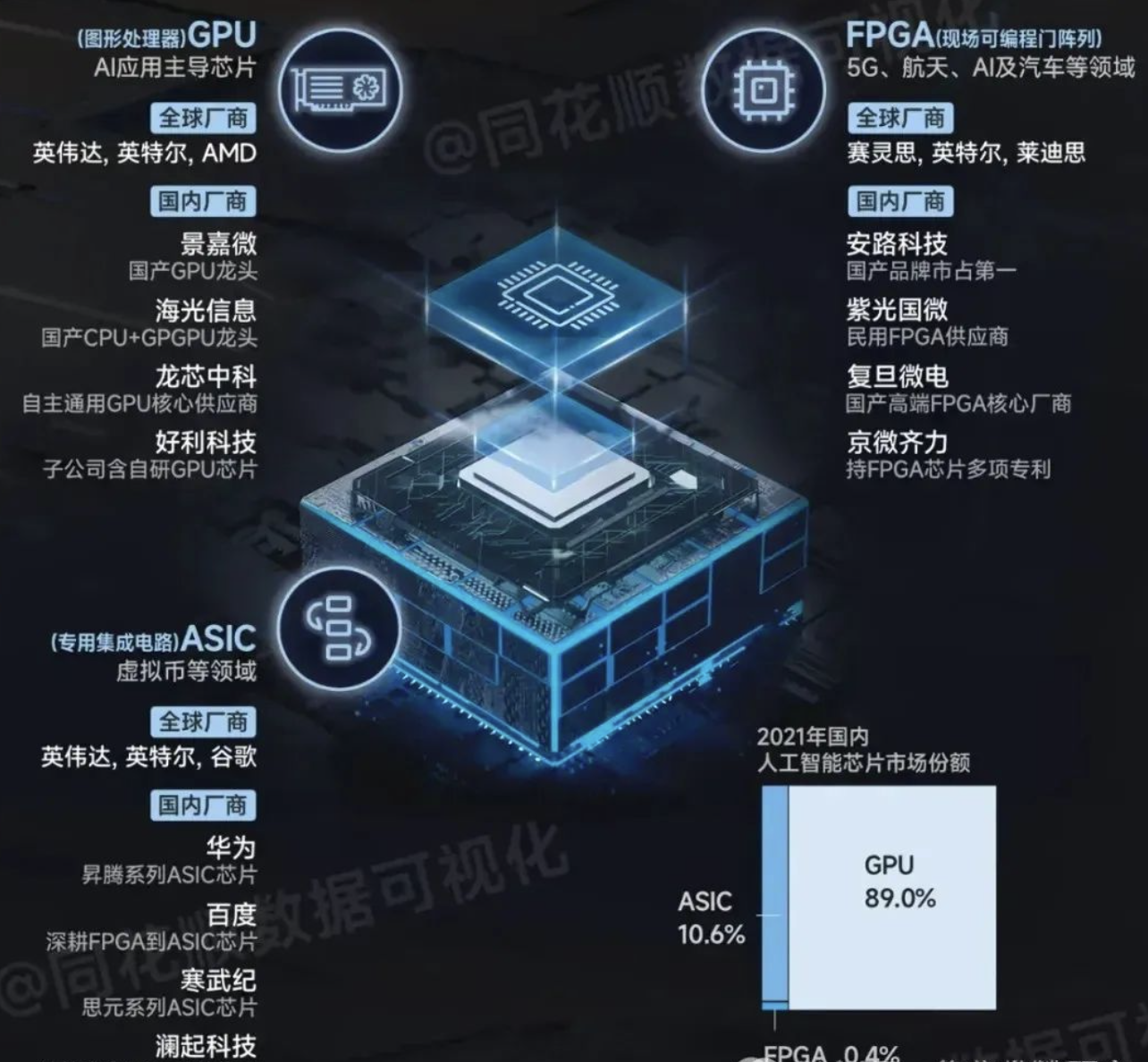

Q:ASIC芯片为何被认为是取代GPU的趋势,并且它的技术和GPU技术相比有何优势?

A:ASIC芯片因其功耗较小、价格相对便宜,性价比更高,因此被认为是取代GPU的一个新型技术方向。类似于5G基站中用ASIC代替FPDA的趋势,ASIC在技术上具有竞争力。同时,谷歌等科技巨头研发的TPU芯片的成功应用,以及对高性能和能效比的优化需求,推动了ASIC芯片在云厂商和AI训练推理领域的广泛应用。

Q:ASIC芯片能否满足推理侧大模型的需求?

A:实际上,对比如今谷歌推出的TPUV5系列,其中既有推理芯片也有训练芯片,这些芯片实际上可以满足包括训练在内的多种需求,打破了人们只适用于推理的误解。

Q:谷歌的TPU设计对于大规模深度学习和矩阵乘法加速很适合,但是否适用于所有类型的深度学习模型,比如大语言模型(LLM)?

A:TPU的设计确实非常适合大规模深度学习和矩阵乘法计算,但在处理大语言模型等方面并不具有通用性,它更偏向于谷歌自家的一些特定模型。

Q:目前在业界中,哪一家公司在训练方面的芯片性能和通用性最强?

A:目前英伟达在训练领域的芯片无论从算力、通用性还是编程环境来看,都是业界最先进的。尽管有其他竞争者,例如谷歌、Meta和亚马逊等,但在整个产业界,英伟达芯片的地位依然难以动摇,尤其在大语言模型训练方面,如OpenAI的ChatGPT,英伟达芯片仍是首选。

Q:在算力和功耗方面,H100与TPU5E相比有何差异?

A:H100的算力强大,接近4000到8000个tops,而TPU5E的算力相对较小,采用定点预测方式,浮点预测算力大概在400到500左右。在功耗方面,H100的功耗大约在700万左右,远高于TPU5E的200万左右。

Q:对于大模型训练所需的大量内存,H100和TPU5E有何不同?谷歌和其他公司(如Meta、亚马逊)在设计AI加速器时的理念是什么?

A:H100配备的HBM内存达到188GB,而TPU5E的内存只有大约95至100GB左右,大约是H100的一半。谷歌和其他公司意识到如果完全与英伟达竞争算力,可能会陷入同样高的功耗选择困境。因此,他们致力于设计功能可能不如英伟达但能实现更好的芯片,比如最新推出的V6芯片可以实现10万片的,从而带来显著优势。

Q:价格方面,谷歌TPU与英伟达H100相比有何优势?

A:在价格方面,谷歌TPU5E的价格大约在2000到3000美金,而英伟达H100的价格可能高达5万美金左右,因此TPU在性价比上表现优秀,例如基于TPU5P的云服务每小时运算成本可低至八毛钱左右,远低于英伟达H100可能需要的几倍甚至10块钱1小时的成本,并且随着更新一代代的芯片推出,这一优势愈发明显。

Q:谷歌在芯片采购上,对英伟达芯片的需求情况如何?

A:谷歌自身使用的TPUV51V5P芯片数量超过百万片,相较于采购的20万片英伟达芯片,显示出其对英伟达大规模训练芯片的需求较少。不过,谷歌对于推理性芯片的需求可能更大,特别是针对特殊模型如former模型和cancer模型等,可以用TTPU的V5P进行训练。

Q:目前对英伟达芯片需求量最大的两家公司是哪些?

A:目前对英伟达芯片需求量最大的两家公司是Meta和微软,这两家公司主要依赖于英伟达芯片进行大语言模型的训练,每家大约采购60万片左右。

Q:国内哪些公司在使用或接受S卡(GPU)方面表现较高?

A:国内对于基于大模型训练或推理需求较高的公司有阿里巴巴、腾讯、百度和字节跳动。其中,百度更侧重于自动驾驶和其他搜索业务;字节跳动则关注视频、内容生成与推荐等方面;阿里巴巴在中国作为提供云服务的大公司,其使用情况类似于亚马逊;腾讯业务更接近Meta,涉及、视频和AR/VR等领域。

Q:国内是否有公司有出货量的S卡,以及他们在AI芯片设计上的现状如何?

A:目前在国内,阿里巴巴、百度等公司在研发自家架构的AI芯片,但尚未实现大规模试用或应用到核心的大语言模型或AI加速上。可能的原因包括受到美国限制导致无法获得先进的制程产能,以及国内芯片设计公司目前在针对特殊模型定制化设计方面缺乏成熟能力,相较于博通、联发科等国际成熟企业存在滞后。

Q:对于ASIC设计服务商的市场格局,有哪些主要阵营?

A:ASIC设计服务商市场主要以马威尔(Marvell)和BrownTown(和辉光电)为首,这两家公司拥有较长的设计服务历史和先进的设计流程,能够保证一次流片成功。其中,马威尔通过收购GlobalFoundry的设计服务团队进一步强化了其服务能力,并且成为了微软的长期客户。

Q:MTK联发科等公司在AI加T芯片市场中的定位是什么?

A:MTK联发科等公司虽然不是传统意义上的设计服务商,但它们拥有很强的芯片设计能力,最初从消费电子领域如手机、DVD/VCD等产品起步,并逐渐扩展到面向企业及AI领域的芯片设计。不过,在IP丰富性和整体设计能力上,相较于第一阵营的公司仍稍显不足。

Q:目前AI加T芯片市场的主要玩家有哪些?市场分布如何?

A:在AI加T芯片市场中,主要的两家玩家是博通和马威尔,其中博通占据约70%的市场份额,马威尔占据接近30%的市场份额。博通的主要客户包括谷歌、Meta、亚马逊、字节跳动(OpenAI)以及可能的苹果公司;而马威尔的主要客户则是微软。

Q:目前各大公司的AI芯片出货量情况如何?

A:目前出货量还未达到高位,除了谷歌外,其他公司的出货量相对较低。谷歌今年出货量约120万片,主要来自V5P和V5P芯片,预计明年出货量将超过150万片,部分销售量来自V6芯片。Meta经过芯片改版后,明年出货量预计将达到30万片左右。亚马逊有两款芯片(推理和训练),今年出货量较小,明年预计接近50万片。字节跳动的芯片预计明年下半年开始大规模出货,初期量不大,但后续规模会接近30万片。OpenAI研发还在进行中,预计2026年初会推出芯片,初期规模约10万片。苹果公司目前还处于早期阶段,预计2026年出货,规模也将约为10万片。

Q:TPU芯片在市场中的地位如何?其应用场景有哪些?

A:谷歌定制的TPU芯片在市场芯片供给量和出货量方面均排名第一。TPU主要应用于谷歌自身服务,如搜索(图像搜索和视频搜索)、YouTube以及GoogleCloud的数据中心深度学习服务,尤其是基于transformer模型的应用场景。目前,由于美国尚未对设计服务公司如博通、马威尔等对中国大陆公司的直接禁运,因此尚未触发相关风险,但未来是否存在禁令风险仍不确定。

Q:在国内,寒武纪等芯片公司在自动驾驶市场与其他领域的应用上,与美国芯片公司相比是否存在较大差距?

A:是的,国内芯片公司在某些特定市场如自动驾驶领域有一定的应用优势,但在通用AI加速领域,包括中国的芯片公司在内的整体水平与美国芯片公司相比仍有较大差距。美国政府并不认为这是一个威胁,因此短期内不会实施禁令。

Q:谷歌在未来是否会减少对中国客户依赖,转向自行设计芯片?

A:谷歌正逐步减少对博通等外部供应商的依赖,其内部设计团队能力较强,并有可能在未来两三年内逐步转向内部研发芯片。博通的很多增长点可能需要来自海外客户,包括中国的客户。

Q:光模块技术路线或发展趋势是否会因新技术如800G、1.6T、LPO以及CPU的发展而发生变化?

A:光模块技术的发展趋势确实会发生变化。800G和1.6T光模块仍以可插拔为主,但到2026年左右,随着CPU形态的成熟和量产,可插拔光模块将会逐渐被淘汰,转而出现更高效的全硅光集成互联方式。目前,包括硅光芯片在内的相关技术和工艺正在由国内外多个厂商进行研发和布局。

Q:硅光集成技术在未来的发展前景如何,以及会带来哪些市场变化?

A:硅光集成技术是未来的趋势,台积电等厂商将推动该技术的发展,预计到2028年相关产业供应链会趋于成熟。这将带来市场中极大变化,如交换机和硅光光电模块的集成度提高,新材料需求增加(如新的封装材料和光纤等),同时也可能导致部分传统交换机相关市场的萎缩(如PCB市场)。此外,随着硅光技术的应用,对特定组件如CW光源的需求也会有所增长。

Q:对于伊朗和整个数据中心的热管理和冷却技术,液冷等新技术的应用会带来哪些变化?

A:液冷或改进的冷却技术使得数据中心的冷却方式更为简单高效,从而提高了整体能效,降低了在冷却基础上的压力,对市场产生较大影响。全产业链研究

水晶球APP

高手云集的股票社区

X

公安备案号 51010802001128号

公安备案号 51010802001128号